Predictim è un servizio online, al pari di altre aziende che vendono anche “sistemi per i datori di lavoro che analizzano il linguaggio, le espressioni facciali e la storia online di una persona”, utilizza l’intelligenza artificiale per tracciare l’impronta digitale di una baby-sitter, analizza i post su Facebook, Twitter e Instagram dei candidati per offrire automatizzate “valutazioni del rischio” per abuso di droghe, bullismo, molestie, mancanza di rispetto o cattiva condotta.

La tecnologia sta ridisegnando il modo in cui alcune aziende affrontano il reclutamento, l’assunzione e la revisione dei lavoratori, offrendo ai datori di lavoro un supporto senza eguali per scegliere i candidati al lavoro attraverso una nuova invasiva valutazione e sorveglianza psicologica, per esempio:

– HireVue, lavora con aziende come Geico, Hilton e Unilever, offre un sistema che analizza automaticamente il tono, la scelta delle parole e i movimenti facciali dei candidati durante le interviste video per predire la loro abilità e contegno sul lavoro (i candidati sono incoraggiati a sorridere per i migliori risultati);

– Fama, un’azienda tecnologica ha affermato di utilizzare l’intelligenza artificiale per controllare i social media dei lavoratori per valutare i comportamenti “tossici” e allertare i loro capi.

I critici sostengono che Predictim e sistemi simili presentano i propri pericoli rendendo le decisioni automatiche, potenzialmente modificabili e incontrollate. I sistemi dipendono da algoritmi che forniscono pochi dettagli su come analizzano le complessità della vita interiore di una persona in un calcolo di virtù o danno.

Sal Parsa capo e co-fondatore di Predictim ha detto:

«La società, lanciata lo scorso mese valuta seriamente le questioni etiche sull’uso della sua tecnologia. Il pericolo di assumere una baby-sitter problematica o violenta, rende l’intelligenza artificiale, uno strumento necessario per ogni genitore che spera di tenere al sicuro il suo bambino. Se stai cercando baby-sitter violente, su Google vedrai centinaia di risultati in questo momento, c’è gente là fuori che soffre di una malattia mentale, o è nata male. Il nostro obiettivo è fare tutto il possibile per fermarli».

La scansione di Predictim parte da 24,99 dollari, richiede il nome e l’indirizzo e-mail di una baby-sitter e il suo consenso a condividere un accesso completo ai suoi account sui social media. La baby-sitter può rifiutare, a un genitore è comunicato il suo rifiuto. La baby-sitter in un’e-mail è informata che “il genitore interessato non sarà in grado di assumerti finché non completi la richiesta”.

I dirigenti di Predictim per valutare i post della baby-sitter su Facebook, Twitter e Instagram per indizi sulle loro vite offline, affermano di utilizzare algoritmi di elaborazione del linguaggio e software di riconoscimento d’immagini note come “computer vision”.

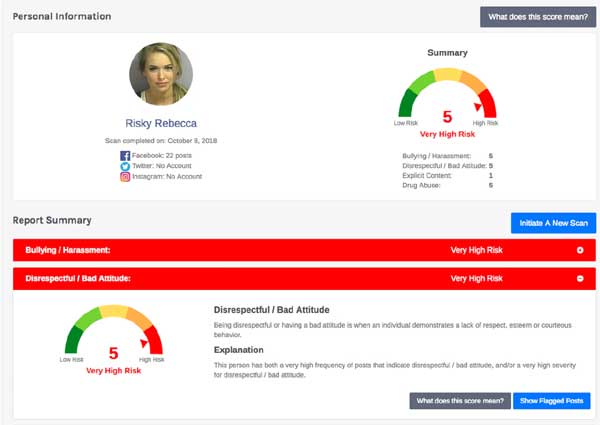

Le valutazioni del rischio sono suddivise in diverse categorie, tra cui il contenuto esplicito e l’abuso di droghe. Hanno annunciato che Predictim può valutare le baby-sitter anche su altri tratti della personalità, come la gentilezza, la capacità di lavorare con gli altri e la “positività”.

Perplessità su Predictim

Gli esperti di tecnologia dicono che il sistema solleva dubbi, in particolare s’interrogano su come questi sistemi sono addestrati e su come potrebbero essere vulnerabili a interpretare erroneamente i significati indistinti del loro uso nei social media.

I genitori tranne che per scansioni a rischio più elevato, ricevono solo un suggerimento di comportamento discutibile e nessuna frase specifica, link o dettagli da valutare indipendentemente. E’ accaduto che quando una madre dopo aver richiesto e ricevuto la segnalazione di una baby-sitter per possibili comportamenti di bullismo, si è arrabbiata, ha affermato di non poter dire se il software avesse identificato una citazione da un vecchio film, una canzone o altra frase che contraddice il vero linguaggio del bullismo.

Jamie L. Williams, avvocato dello staff del gruppo delle libertà civili dell’Electronic Frontier Foundation, ha affermato che la maggior parte degli algoritmi utilizzati per valutare il significato delle parole e delle immagini online sono ampiamente noti per non interpretare il contesto e il buon senso del lettore umano; anche giganti della tecnologia come Facebook hanno faticato a costruire algoritmi che distinguono tra commenti innocui e discorsi d’incitamento all’odio.

Intelligenza artificiale non sempre perfetta nel valutare la baby-sitter

Malissa Nielsen, baby-sitter ha 24 anni, recentemente ha dato la sua approvazione a due famiglie che le hanno chiesto di fornire accesso ai social media a Predictim. Ha detto:

«Sono sempre stata attenta ai social media, vado in chiesa una volta la settimana, non maledico, sto completando gli studi per una laurea in educazione della prima infanzia, con la quale spero di aprire un asilo.

Sono rimasta stupita dopo aver appreso che il sistema mi ha dato voti imperfetti per azioni di bullismo e la mancanza di rispetto. Credevo di consentire ai futuri datori di lavoro di valutare i miei social media, non accetto di avere la mia personalità sezionata da un algoritmo. Inoltre, non mi è stato detto che i risultati per un test potessero paralizzare la mia unica fonte di reddito. Il computer non ha sentimenti, non può determinare diversi aspetti che riguardano la sfera emotiva e comportamentale di una persona”.